SEJAK Januari 2024, 454 kes penipuan disiasat oleh Bahagian Siasatan Jenayah Komersial (CCID) Polis Diraja Malaysia membabitkan teknologi video (deepfake) dan audio palsu (voice cloning) yang meniru suara rakan malah ahli keluarga melalui WhatsApp menyebabkan kerugian RM2.72 juta.

Polis menjejaki sekurang-kurangnya lima video deepfake (palsu tulen) menggunakan imej tokoh terkenal seperti Perdana Menteri, Datuk Seri Anwar Ibrahim, Elon Musk, serta wakil rakyat Teresa Kok, yang digunakan untuk menipu orang ramai menyertai skim pelaburan palsu.

Mereka menyamar sebagai selebriti tempatan seperti Siti Nurhaliza dan Fazley Yaakob, menipu pengguna melalui video WhatsApp yang kelihatan asli, sehingga ada pengikut memberi bantuan kewangan kerana mempercayai video itu.

Manusia mencipta AI untuk kebaikan dan sepatutnya ia digunakan untuk perkara berfaedah.

Menurut laporan CCID, kerugian dari kes pelaburan dan penipuan mencecah RM1.4 bilion pada 2024, dan jumlah itu terus meningkat pada suku pertama 2025 (RM573.7 juta dalam tiga bulan pertama) dengan sebahagiannya membabitkan scam AI seperti deepfake (palsu tulen) dan voice cloning (mengklon suara atau suara palsu).

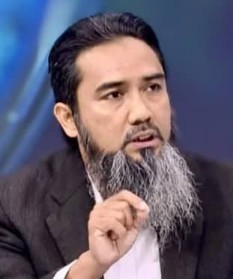

Ahli Panel Transformasi Digital, Zahari Ghani, berkata AI bukan perkara baharu malah masyarakat menggunakan setiap hari di pejabat atau di rumah. Ia berada dalam telefon bimbit.

"AI tak salah tapi ia menjadi kesalahan apabila ia disalahgunakan untuk tujuan tidak baik contohnya kita buat untuk suara palsu, tiru imej palsu, dan guna AI untuk kawal emosi manusia.

Zahari Ghani menjadi tetamu program SPM terbitan RTM.

"Jika ini berlaku, ia menjadi senjata digital yang amat berbahaya. AI sama seperti kita menggunakan pisau, jika digunakan untuk kebaikan seperti memotong makanan, ia memberi kebaikan tapi jika sebaliknya ia boleh membunuh!

"Teknologi AI tidak salah sebab ia dihasilkan untuk kebaikan tapi manusia yang dikurniakan akal lalu menyalahgunakan untuk kepentingan diri sendiri. Jika AI digunakan untuk kebaikan, ia memudahkan kehidupan kita," katanya.

Beliau berkata demikian ketika menjadi tetamu dalam program Selamat Pagi Malaysia (SPM) terbitan RTM dengan tajuk perbincangan, "Apabila Kecerdasan Buatan (AI) disalah gunakan: Etika dan Ancaman Jenayah Baharu!" pada 21 Julai 2025.

Zahari Ghani

Menurutnya, AI bukan jahat, tapi boleh digunakan untuk tujuan jahat jika jatuh ke tangan orang yang salah. Penyalahgunaan seperti deepfake, penipuan suara, diskriminasi data dan senjata autonomi menunjukkan betapa pentingnya pengawasan, undang-undang, dan etika dalam penggunaan AI.

"Rakyat Malaysia apabila menggunakan AI perlu ada ilmu, perlu tahu apa yang boleh dibuat dan tidak. Kita perlu celik digital supaya tahu membezakan imej yang betul dan palsu. Kita juga perlu semak dengan orang kedua atau ketiga bagi mengelak menjadi mangsa penipuan scammer.

"Jika terima video, bertenang dulu, fikir tiga atau empat kali sama ada ia benar atau sebaliknya. Dalam Islam kita ada istilah tabayyun, usah sebar tapi semak atau periksa sama ada ia benar atau palsu," katanya lagi.

AI tak salah tapi ia menjadi mimpi ngeri apabila ia disalahguanakan untuk tujuan tidak baik.

Zahari yang juga Ahli Panel National Cybersecurity (Panel Keselamatan Siber Kebangsaan) mengakui, pihak berkuasa sukar untuk membanteras kegiatan penyalahgunaan AI kerana tiada undang-undang khusus dan kini dalam proses dibawa ke Parlimen untuk digubal menjadi akta.

"Kerajaan dan masyarakat perlu memainkan peranan aktif supaya rakyat celik IT. Kita sukar menghalang scammer melakukan kerja mereka tapi kita perlu latih masyarakat supaya kenal siapa itu scammer dan mengelak menjadi mangsa.

"Kita perlu ada "check and balance", elak buat tindakan melulu. Bayangkan dunia AI, monyet boleh bercakap, Orang Utan pun ada TikTok.

Ini mungkin konsep robot yang bakal menggantikan manusia dalam pelbagai bidang.

"Ia mungkin satu ancaman kepada golongan warga emas kerana mereka kurang mahir dan kurang cakna mengenai AI dan mudah menjadi sasaran scammer.

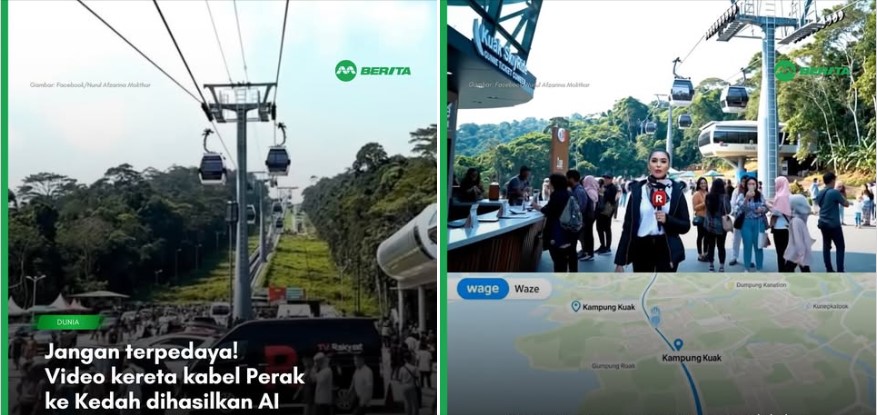

"Seorang wanita warga emas yang melihat video promosi pelancongan, tertarik untuk menempah penginapan apabila dikatakan ada kereta kabel. Akhirnya wanita itu kerugian beribu-ribu ringgit," katanya.

Justeru, beliau meminta anak-anak membantu menerangkan kepada ibu bapa supaya berhati-hati dengan video di media sosial, usah mudah terpedaya dan jika melihat sesuatu video yang luar biasa, periksa dulu dengan anak-anak. - KitaReporters

LAPORAN mengenai video kereta kabel yang menggunakan teknologi AI.